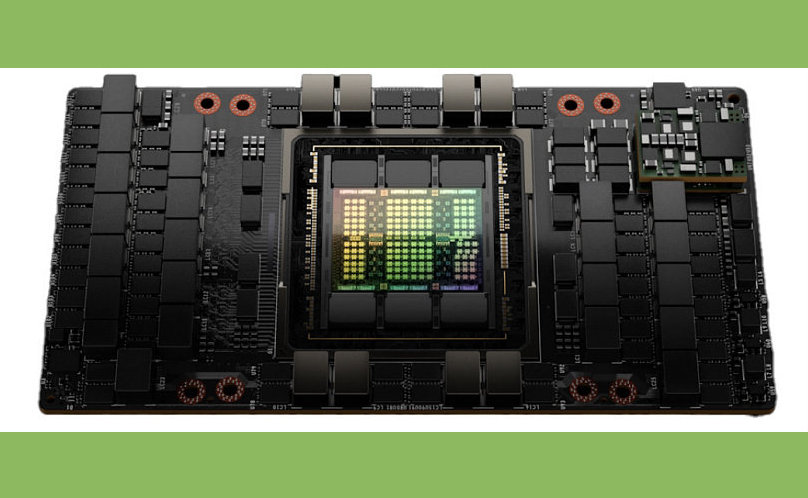

Nvidia H100 — это графический процессор (GPU) для центров обработки данных, выпущенный компанией Nvidia в 2022 году. Его основное назначение — ускорение вычислений в задачах искусственного интеллекта (AI), машинного обучения, высокопроизводительных вычислений (HPC) и работы с большими данными.

На изображении показан Nvidia H100 в исполнении SXM (SXM5 модуль) — это не видеокарта в привычном виде, а серверный модуль, который устанавливается на материнскую плату дата-центровых систем (например, HGX H100 или DGX H100).

То есть на фото — именно вычислительный модуль, и его масса меньше килограмма.

Ключевые особенности H100:

Архитектура Hopper — новое поколение GPU, пришедшее на смену архитектуре Ampere (A100).

Ориентирован на AI: оптимизирован для работы с нейросетями, особенно генеративными моделями (LLM вроде GPT-4, Claude, Gemini и т.д.).

Производительность:

до 60 ТФлопс FP64 (двойная точность).

до 1000+ ТФлопс в режимах с низкой точностью (FP8, INT8), что важно для обучения и инференса больших моделей.

NVLink 4.0 — высокоскоростное соединение между GPU для масштабирования в суперкомпьютеры.

HBM3 память — до 80 ГБ сверхбыстрой памяти с пропускной способностью более 3 ТБ/с.

Поддержка MIG (Multi-Instance GPU), позволяющая делить один H100 между несколькими пользователями.

H100 от Nvidia используется в дата-центрах для обучения и запуска больших языковых моделей (ChatGPT, Claude, Gemini и т.п.); в суперкомпьютерах и облачных сервисах (AWS, Azure, Google Cloud); в проектах, где нужно обучать ИИ на сотнях миллиардов параметров.

Стоимость одного H100 зависит от конфигурации и поставщика и обычно $25 000 – $40 000 за одну карту. В системах вроде Nvidia DGX H100 (8 GPU + CPU + инфраструктура) цена может превышать $300 000.

Если задачи требуют большой универсальности, не только обучения нейронных сетей, возможно A100 будет достаточно и сможет быть более экономичным вариантом, особенно если инфраструктура или бюджет ограничены.

Если модель не такая большая, или нет надобности в экстремально высокой пропускной способности и самого свежего оборудования, A100 может быть «достаточно хорошим».

Если цель — обучение больших языковых моделей (LLMs), генеративных моделей, требующих огромной параллельной работы и работы с FP8 / смешанной точностью, — H100 будет давать значительные преимущества.

Подписывайтесь на телеграм-канал Финсайд и потом не говорите, что вас не предупреждали: https://t.me/finside.

Сообщить о мошенниках или задать вопрос Памятка о возврате от мошенников Телеграм-канал и чат Вкладер Белый список инвестиций